In den letzten Beiträgen auf dem Shift/Work Blog haben wir uns damit beschäftigt, wie KI sinnvoll in den Arbeitsalltag integriert werden kann. Wir haben über Use Cases gesprochen, über neue Fähigkeiten, die es braucht, und darüber, wie wir Mitarbeitende für den Einsatz von KI wie Microsoft Copilot gewinnen können. Zwei zentrale Texte dazu: „Arbeit neu denken – KI-Enablement als Hebel für smarte Zusammenarbeit“ und „Die smarte Zusammenarbeit von morgen optimieren“.

Doch die Diskussion über die Einführung von KI am Arbeitsplatz greift an vielen Stellen noch zu kurz. Es reicht nicht, über Nutzungsmethoden, Akzeptanz oder Schulungen zu sprechen. Denn LLM-basierte Systeme wie Copilot kommen längst nicht mehr nur bei der Textgenerierung zum Einsatz. Sie unterstützen bei der Zusammenfassung von Meetings, bei der Auswertung gesprochener Sprache, bei der Analyse von E-Mails, bei der Strukturierung von Aufgaben oder als kleine Prozesshilfen im Hintergrund. Sie greifen tief in den Arbeitsalltag ein – und arbeiten dabei auf Basis dessen, was technisch verfügbar ist. Nicht auf Basis dessen, was geprüft, gültig oder gewollt ist.

Deshalb müssen wir uns intensiver mit dem Thema Governance beschäftigen. Nicht, weil sie den Einsatz von KI einschränkt – sondern weil sie ihn möglich macht. Eine gut aufgestellte Governance schafft Vertrauen, sorgt für Klarheit und unterstützt die Einführung von KI im Unternehmen. Genau darüber sprechen wir auch beim kommenden Digital Work Forum. Und mit diesem Beitrag bereiten wir diese Diskussion vor.

Warum Governance jetzt auf die Agenda gehört

Wenn wir heute über Copilot oder andere KI-gestützte Assistenten sprechen, klingt vieles einfach. Eine Frage eingeben, eine Antwort erhalten – so lautet das Versprechen. Und auf den ersten Blick scheint es auch zu stimmen: Die Technologie funktioniert. Sie antwortet schnell, formuliert flüssig, wirkt kompetent. Doch genau an dieser Stelle beginnt das Missverständnis. Denn was in der Oberfläche einfach erscheint, ist im Hintergrund alles andere als trivial.

Sprachmodelle wie Copilot erzeugen keine geprüften Fakten, sondern Textvorschläge auf Basis von Daten, auf die sie zugreifen dürfen. Und genau hier wird es kritisch: In der Regel definiert nicht das System selbst, worauf es zugreift, sondern die Nutzer:innen. Sie entscheiden, welche Ressourcen sie freigeben – und in welchem Kontext Copilot aktiv wird. Das kann eine Datei sein, aber auch ein Meeting, in dem Copilot zuhört, mitprotokolliert oder Aufgaben vorschlägt. Oft passiert das, ohne dass alle Beteiligten wissen, was genau analysiert wird – oder wie die Auswertung später verwendet wird.

So gelangen nicht nur alte Arbeitsversionen aus dem persönlichen OneDrive ins System, sondern auch sensitives Wissen aus Gesprächen, das nie schriftlich festgehalten worden wäre. Copilot unterscheidet nicht zwischen „reif für die Nutzung“ und „eigentlich nicht gedacht für diesen Kontext“. Was technisch erreichbar ist – inhaltlich oder situativ –, fließt potenziell in die Antwort mit ein. Microsoft selbst weist darauf hin, dass Copilot „nur so hilfreich ist wie die zugrundeliegenden Daten und Zugriffsrechte“ – und dass eine saubere Berechtigungsstruktur eine Grundvoraussetzung für den Einsatz ist. (Quelle: Microsoft)

Genau deshalb brauchen wir Governance. Denn je tiefer sich KI-Systeme in die Arbeitsprozesse integrieren, desto mehr hängt ihr Wert vom Umfeld ab, in dem sie operieren. Governance sorgt dafür, dass Copilot nicht zum Zufallsgenerator wird. Sie regelt, was zugänglich ist, welche Inhalte gelten, und wo die Grenzen verlaufen. Ohne diese Rahmenbedingungen entsteht ein gefährlicher Mix: technischer Zugriff ohne inhaltliche Absicherung.

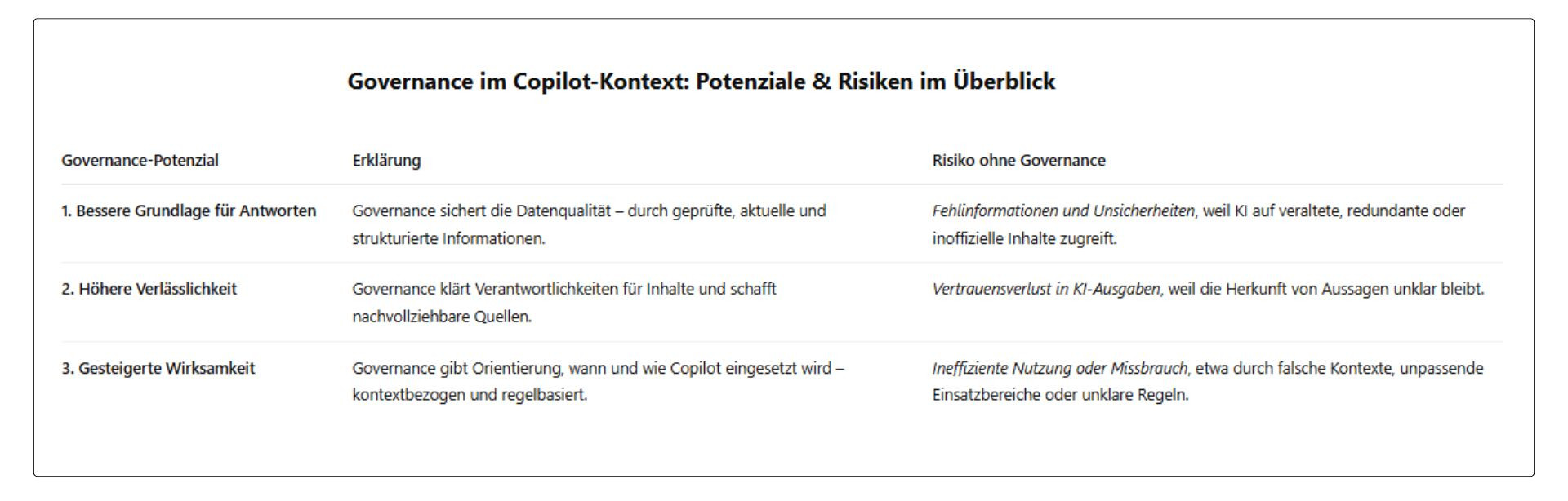

Aber Governance ist mehr als Risikobegrenzung – sie ist ein echter Produktivitätshebel. Ein strukturierter Zugriff auf geprüfte, aktuelle und kontextbezogene Informationen sorgt dafür, dass die Ergebnisse von Copilot und anderen Assistenten verständlicher, relevanter und vertrauenswürdiger werden. Das reduziert Nacharbeit, erhöht die Nutzungsakzeptanz und steigert die Qualität von Entscheidungen. Kurz gesagt:

- Governance verbessert die Grundlage der Antworten, weil sie die Datenqualität systematisch sichert.

- Governance erhöht die Verlässlichkeit, weil klar ist, wo Informationen herkommen und wer sie verantwortet.

- Governance steigert die Wirksamkeit, weil sie Orientierung gibt, wie KI in Prozessen sinnvoll eingesetzt wird.

Diese Herausforderung ist kein Microsoft-Problem – sie gilt für alle LLM-basierten Systeme im Unternehmenskontext. Eine Analyse von Kyndryl bringt es auf den Punkt:

Without proper guardrails in place, users may misuse the technology or expose sensitive data that can cause significant operational, financial or reputational damage. (Quelle: Kyndryl)

Wer also über die Einführung von KI am Arbeitsplatz nachdenkt, kommt an diesen Fragen nicht vorbei: Was darf genutzt werden? Was ist freigegeben? Und wer trägt dafür Verantwortung? Governance ist kein Stolperstein. Sie ist das, was den Einsatz tragfähig macht – für alle Beteiligten.

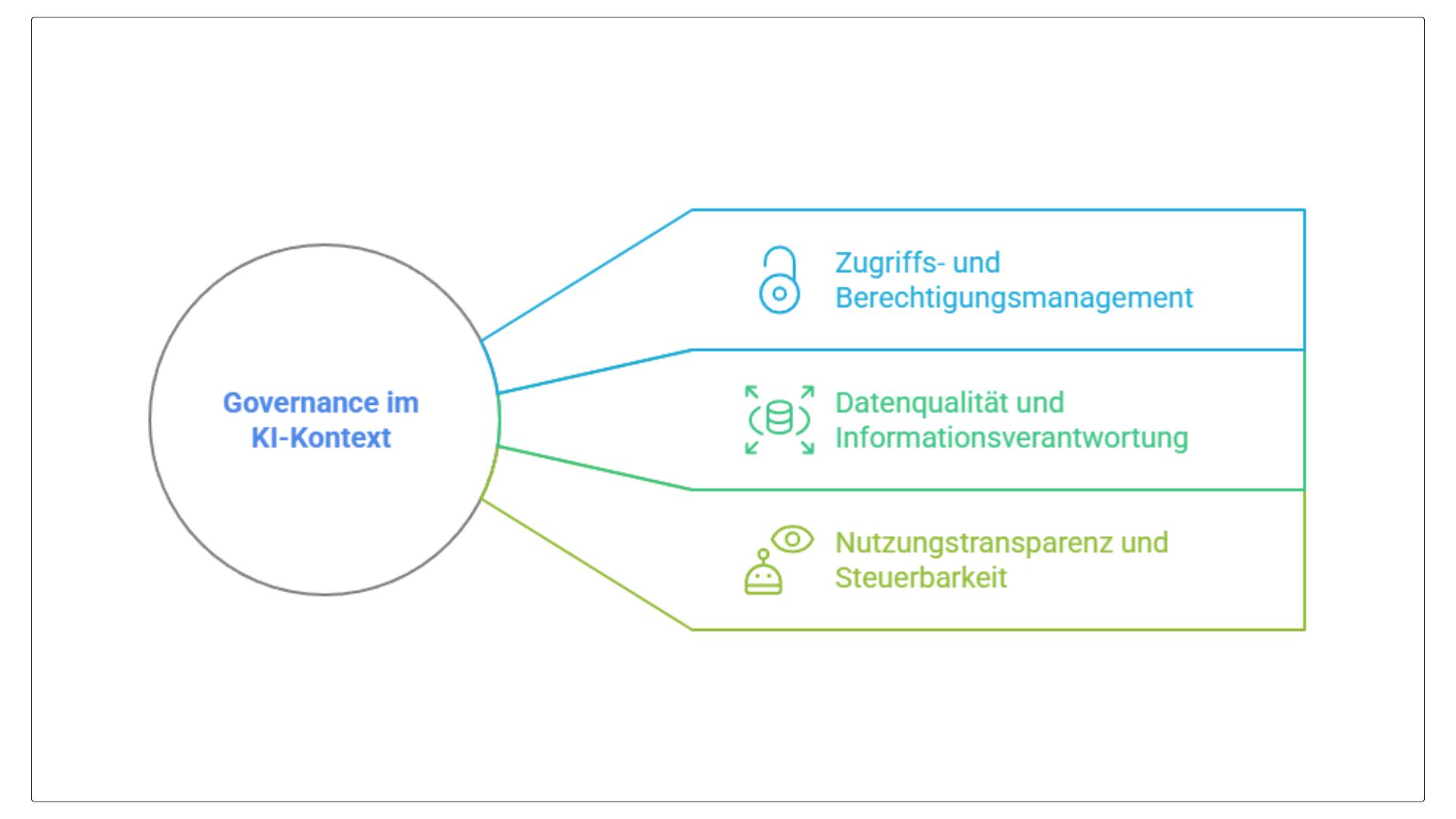

Was Governance im KI-Kontext konkret bedeutet

Wenn wir über Governance im Zusammenhang mit Copilot oder anderen KI-Systemen sprechen, geht es nicht um ein einzelnes Regelwerk. Es geht um ein Zusammenspiel aus klaren Zuständigkeiten, transparenter Zugriffskontrolle und einer verlässlichen Datenbasis. Damit Copilot im Unternehmen sinnvoll genutzt werden kann, müssen mehrere Ebenen zusammengedacht werden – technisch, organisatorisch und inhaltlich.

1. Zugriffs- und Berechtigungsmanagement

Im Zentrum steht die Frage: Wer darf worauf zugreifen – und warum? Viele Unternehmen haben in den letzten Jahren bereits Strukturen aufgebaut, insbesondere im Rahmen der Microsoft-Teams-Governance. Durch Rollenmodelle, standardisierte Berechtigungsstrukturen und automatisierte Team- und Site-Erstellung wurde vielerorts die Grundlage gelegt, um Zugriff sinnvoll und nachvollziehbar zu steuern.

Diese Erfahrungen sind heute Gold wert. Denn Copilot greift genau auf diese Strukturen zurück – über Microsoft Graph, SharePoint, OneDrive und Teams. Wenn Zugriffe transparent und bereinigt sind, kann Copilot auf dieser Basis relevante Informationen liefern. Wenn jedoch Schattenstrukturen, Überberechtigungen oder verwaiste Inhalte bestehen bleiben, potenziert Copilot genau diese Probleme.

Microsoft beschreibt in seiner internen Governance-Leitlinie zur Copilot-Einführung, dass klare Container-Labels, automatisierte Berechtigungsvergabe und nachvollziehbare Ablagestrukturen eine der wichtigsten Voraussetzungen für eine funktionierende Berechtigungskontrolle sind. (Quelle: Microsoft)

2. Datenqualität und Informationsverantwortung

Copilot arbeitet mit dem, was ihm zur Verfügung steht. Die Qualität seiner Ergebnisse hängt also unmittelbar von der Güte, Aktualität und Einordnung der Inhalte ab. Wer heute bereits mit Sensitivitätskennzeichnungen, Data Loss Prevention oder Metadatenstrukturen arbeitet, hat einen Vorsprung. Diese Mechanismen helfen dabei, Informationen nicht nur zu schützen, sondern auch zu strukturieren – und das ist für den KI-Einsatz entscheidend.

Doch die Realität zeigt: In vielen Unternehmen fehlen klare Kriterien, welche Informationen als gültig, geprüft oder entscheidungsrelevant gelten. Arbeitsversionen, Redundanzen und nicht gepflegte Speicherorte gehören zum Alltag. Governance heißt hier: Verantwortung für Inhalte übernehmen – nicht zentral, sondern dezentral organisiert.

Dazu gehört auch ein neues Mindset auf Nutzendenseite. Denn mit Copilot verändert sich die Bedeutung von Inhalten: Aus einer Datei wird plötzlich eine Entscheidungsgrundlage. Was bislang im Hintergrund lag, wird aktiv genutzt – oft automatisiert, oft unbemerkt. Das erfordert ein Bewusstsein dafür, dass Informationspflege kein Nebenprodukt ist, sondern Teil des produktiven Arbeitens. Microsoft beschreibt diese Anforderung an Datenkurationsprozesse als einen kritischen Erfolgsfaktor für die Qualität von Copilot-Ergebnissen. (Quelle: Microsoft)

3. Nutzungstransparenz und Steuerbarkeit

Copilot integriert sich in den Arbeitsfluss – und genau das macht es schwierig, den Überblick zu behalten. In welchem Meeting war Copilot aktiv? Welche Inhalte wurden zusammengefasst? Wer hat welche Prompts genutzt – und mit welchem Ergebnis?

Transparenz über diese Prozesse ist keine Kontrolle im klassischen Sinn. Es geht nicht darum, jede Interaktion zu überwachen, sondern darum, Nutzung sichtbar, Feedback möglich und Regeln wirksam zu machen.

Auch hier gibt es Vorbilder: In der Governance für Teams oder SharePoint wurden Reportingstrukturen, Nutzungsrichtlinien und Eskalationswege etabliert, um Ordnung und Freiräume auszubalancieren. Diese Logik lässt sich übertragen – und weiterentwickeln. Etwa durch:

- definierte Einsatzbereiche für Copilot,

- klare Prompt-Guidelines,

- Unterstützung durch Schulungen und Beispiele guter Praxis.

Wichtig ist: Jede Form von Auswertung, Kontextanalyse oder Systemeinsatz im Arbeitsprozess muss datenschutzrechtlich geklärt und mit dem Betriebsrat abgestimmt sein. Die Nutzung von Copilot in Meetings oder zur Analyse von Interaktionen berührt mitbestimmungsrelevante Fragen – von der Überwachung bis zur Leistungsbewertung. Microsoft stellt dazu klar, dass Copilot keine personenbezogenen Daten auswertet, sondern nur auf Inhalte zugreift, für die der oder die Nutzer:in über explizite Leserechte verfügt. Der Schutz der Privatsphäre sei ein zentrales Designprinzip. (Quelle: Microsoft)

Governance bedeutet an dieser Stelle nicht weniger Nutzung, sondern bessere Nutzung. Und sie schafft Vertrauen – bei den Mitarbeitenden, in der Organisation und gegenüber der Öffentlichkeit.

Fazit: Governance schafft Orientierung im dynamischen Wandel

Die Einführung von Copilot und vergleichbaren KI-Systemen markiert nicht nur einen technologischen Umbruch, sondern eine strukturelle und kulturelle Herausforderung für die Arbeitswelt. Governance liefert in diesem Wandel den notwendigen Ordnungsrahmen – nicht als Bremse, sondern als Orientierung, die produktive Nutzung ermöglicht und Vertrauen schafft.

Umso wichtiger ist es, dass wir jetzt darüber nachdenken, wie wir Governance in der Praxis greifbar machen. Wie schaffen wir Klarheit inmitten technologischer Dynamik? Wie bringen wir Verantwortung, Transparenz und Effizienz zusammen – ohne die Menschen zu überfordern, die täglich mit diesen Systemen arbeiten? Diese Fragen betreffen uns alle: IT, Kommunikation, Fachbereiche, Betriebsrat – und nicht zuletzt jede:n einzelne:n Nutzer:in.

Aus dieser Perspektive ergeben sich einige Punkte, die es weiter zu diskutieren und auszuarbeiten gilt:

- Wie operationalisieren wir Governance pragmatisch und anschlussfähig – ohne zu überregulieren?

- Welche Rollen und Zuständigkeiten sind notwendig, um Governance in der Fläche lebendig zu halten?

- Wie bringen wir technische, rechtliche und kulturelle Anforderungen in Einklang?

- Wie können wir Mitarbeitende aktiv einbinden, ohne sie zu überfordern – insbesondere in Fragen der Datenpflege und Kontextsteuerung?

- Welche Governance-Standards und -Tools eignen sich konkret für den Einsatz von LLMs in verschiedenen Unternehmensgrößen?

- Und schließlich: Wie schaffen wir Akzeptanz für Governance als Ermöglichungsfaktor – nicht als Einschränkung?

Diese Fragen greifen wir auch im Rahmen des Digital Work Forums 2025 auf. Dort wollen wir gemeinsam mit Praktiker:innen, Expert:innen und Entscheider:innen diskutieren, wie Governance zur tragfähigen Basis für den Einsatz von KI im Arbeitskontext werden kann – und wie wir diesen Wandel aktiv gestalten. Wir laden dich ein, Teil dieser Diskussion zu sein.

Content Newsletter

Immer über die neuesten Beiträge informiert

- Zugang zu Freemium-Inhalten der Mediathek

- Drei Credits für Freischaltung von Premium-Inhalten

- Monatlicher Content-Newsletter mit Premium-Inhalten

- Zugang zu geschlossener Linkedin-Gruppe

- Besondere Plattform-Angebote über Shift/Work Updates

- Kostenlos für immer!

Wir legen großen Wert auf sachliche und unabhängige Beiträge. Um nachvollziehbar zu machen, unter welchen Rahmenbedingungen unsere Inhalte entstehen, geben wir folgende Hinweise:

- Partnerschaften: Vorgestellte Lösungsanbieter können Partner oder Sponsoren unserer Veranstaltungen sein. Dies beeinflusst jedoch nicht die redaktionelle Auswahl oder Bewertung im Beitrag.

- Einsatz von KI-Tools: Bei der Texterstellung und grafischen Aufbereitung unterstützen uns KI-gestützte Werkzeuge. Die inhaltlichen Aussagen beruhen auf eigener Recherche, werden redaktionell geprüft und spiegeln die fachliche Einschätzung des Autors wider.

- Quellenangaben: Externe Studien, Daten und Zitate werden transparent kenntlich gemacht und mit entsprechenden Quellen belegt.

- Aktualität: Alle Inhalte beziehen sich auf den Stand zum Zeitpunkt der Veröffentlichung. Spätere Entwicklungen können einzelne Aussagen überholen.

- Gastbeiträge und Interviews: Beiträge von externen Autorinnen und Autoren – etwa in Form von Interviews oder Gastbeiträgen – sind klar gekennzeichnet und geben die jeweilige persönliche Meinung wieder.